artificial intelligence

0703 HW _ class summary (2)

보민06

2021. 7. 5. 22:48

로지스틱 회귀 (Logistic Regression)

: 참과 거짓이 같이 분류하는데 사용되는 알고리즘

- 선형 회귀의 직선 --> 1 또는 0 사이의 값을 구분하는 것이 어려움

=> s자 형태의 곡선 그래프 필요

=> 이 때 s자 형태의 그래프의 이름이 logistic에서 착안하여 붙인 분류 알고리즘 - 로지스틱 회귀에서의 딥러닝 --> 정확하게 분류하는 곡선 그리기 위해 사용

학습된 분류선 --> 입력값에 따라 0 또는 1로 잘 분류하는 것이 목표 - 선형 회귀 --> 데이터가 연속형일 때

로지스틱 회귀 --> 범주형(0 또는 1의 형태)일 때 사용

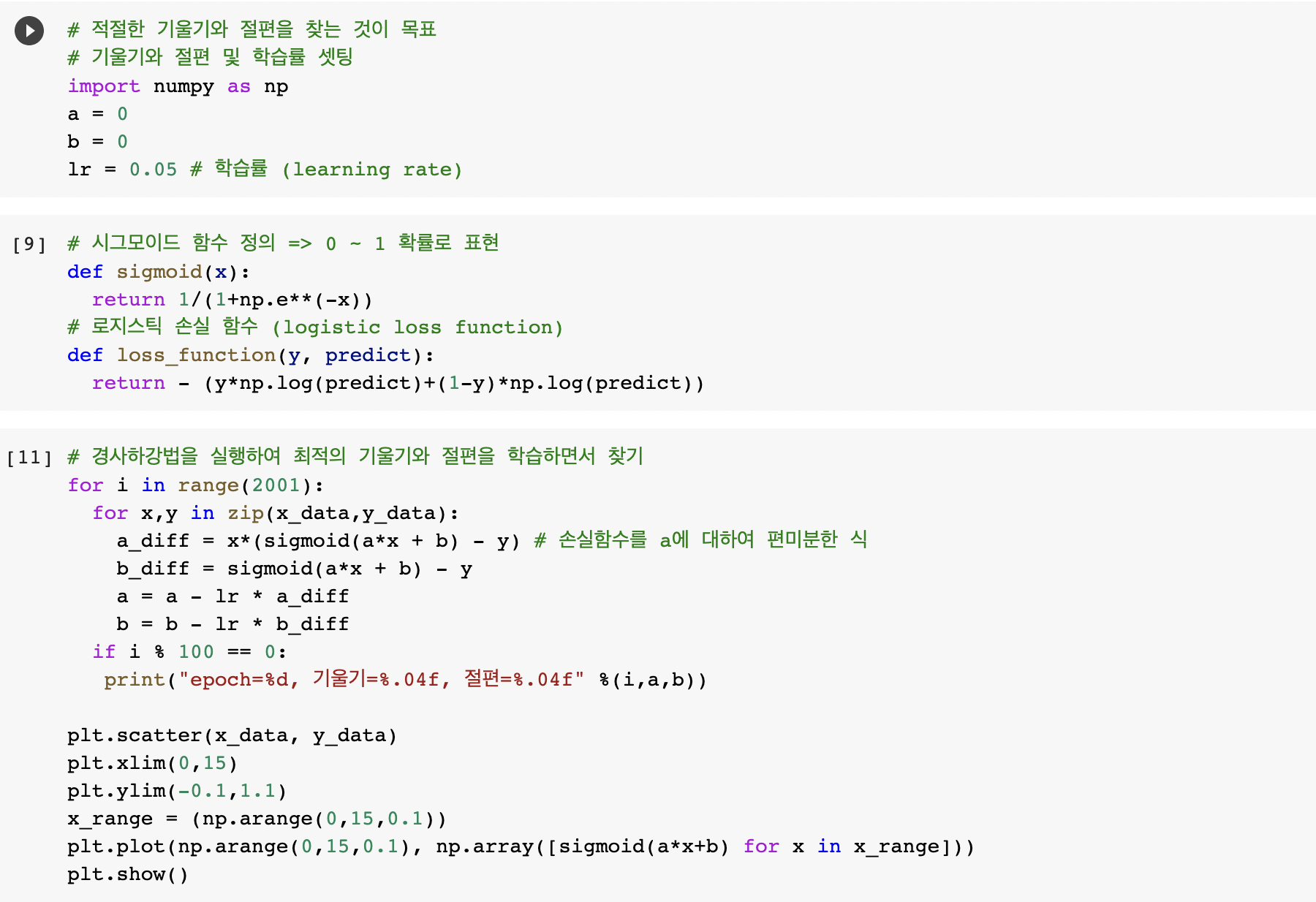

시그모이드 함수 (Sigmoid function)

: 시그모이드 함수(로지스틱 함수)는 s자 형태로 0~1 까지의 확률을 모두 표현 가능

- 이 때 시그모이드 함수는 y = 1/(1 + e^(-z)) 꼴로 z는 선형 방적식인 ax + b가 들어감 (즉, z = ax + b)

- 선형 방정식의 a(기울기) --> 시그모이드 그래프의 경사도 의미, b(y절편) --> 그래프의 좌우 이동 의미

=> a, b 값에 따라 예측값의 정확도 달라짐

오차 공식 (Loss function, Cost function)

: 실제값과 예측값의 차이 = 오차(error)

: 오차들을 계산하는 함수 = 비용 함수 (cost funtion) 혹은 손실 함수 (loss function)

- 선형 회귀의 비용 함수 --> MSE(평균 제곱 오차) 사용

- 로지스틱 회귀의 비용 함수 --> 시그모이드 함수의 특징을 활용하여 로지스틱 손실 함수 (크로스 엔트로피) 사용

- 실제값이 1 --> 예측값이 0에 가까워지면 오차가 커짐, 1에 가까워지면 오차가 작아짐

- 실제값이 0 --> 예측값이 0에 가까워지면 오차가 작아짐, 1에 가까워짐녀 오차가 커짐

로지스틱 손실 함수

: 아래의 두 가지 경우를 한번에 나타낼 수 있는 식 필요

- 실제값이 1 --> 예측값이 0에 가까워지면 오차가 커짐, 1에 가까워지면 오차가 작아짐

- 실제값이 0 --> 예측값이 0에 가까워지면 오차가 작아짐, 1에 가까워짐녀 오차가 커짐

=> 로그 함수를 사용하여 한번에 나타낼 수 있음

L = - (y log (a) + (1 - y) log (1 - a))

* y는 실제값, a는 예측값

내 진로와 딥러닝

: 환자들의 데이터들을 모아 분석한 것을 바탕으로 약의 효능이나 병의 진행 속도를 예측할 수 있을 것 같다